Wanneer AI-systemen context gaan begrijpen.

Bedrijven, beleidsmakers en wetgevers zijn nog druk bezig hun hersenen te breken over de implicaties van ChatGPT in bedrijf en samenleving. Maar nu dient zich de volgende golf van kunstmatig intelligente software alweer aan: multimodaliteit. Dat wil zeggen dat AI-systemen zoals ChatGPT kunnen reflecteren op afbeeldingen, audio en video. Ze kunnen iets begrijpen over de context van visueel materiaal. Dat hebben ze geleerd van afbeeldingen en video’s op het internet.

Voorbeelden

Stel je voor: je wilt je huis online verkopen. Je maakt een paar foto’s en het AI-systeem genereert automatisch een omschrijving van je woonkamer. Of je maakt een foto van een papiertje met een schets van hoe je wil dat je website eruitziet. Dit systeem is een staat om dat om te zetten naar goed werkende computercode en dus een goed werkende website.

Humor uitleggen

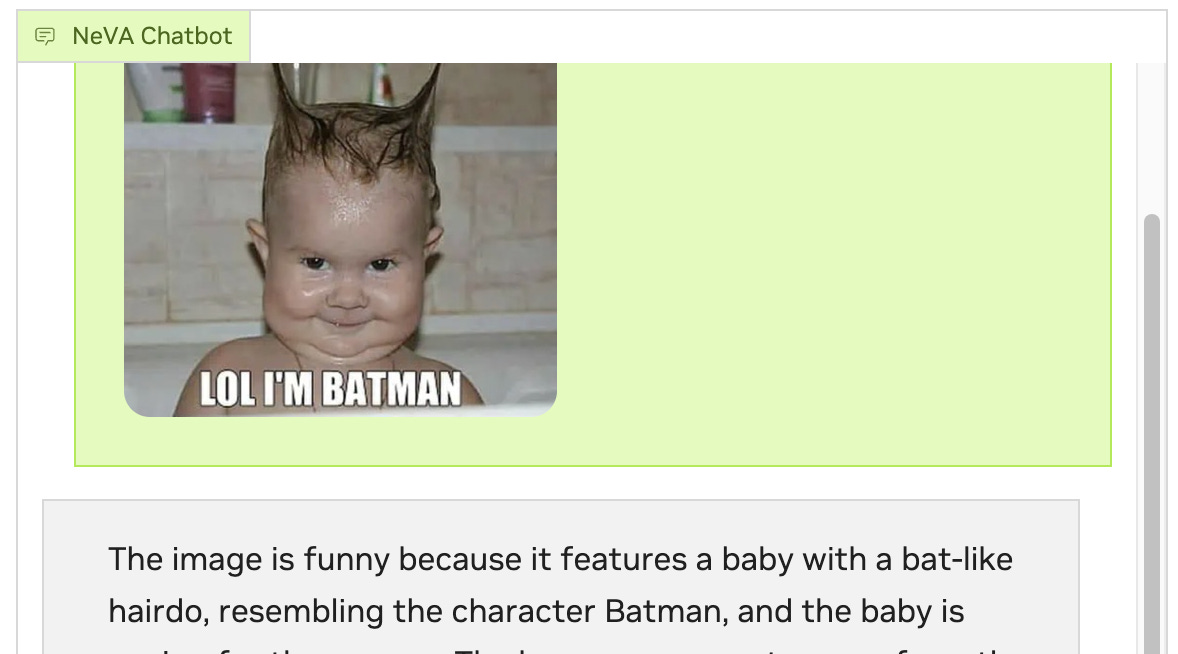

Het meest verbazingwekkend is trouwens dat je een multimodaal AI-systeem een humoristische afbeelding kunt laten zien en het systeem vervolgens perfect kan uitleggen waarom deze afbeelding grappig is. Je uploadt bijvoorbeeld (bij NVIDIA) een foto van een jongetje in een badkuip, met zijn shampoo-haren in Batman oortjes gestyled en de tekst “LoL I’m Batman” eronder. Het systeem antwoordt: De foto is grappig omdat er een baby op staat met een vleermuisachtig kapsel, dat lijkt op het populaire Batman-karakter. Deze combinatie van een jong kind en een bekend stoer cartoon-personage creëert een speelse en vermakelijke scène”. (antwoord iets ingekort, JD)

Complexiteit

Het is zeer bijzonder dat AI-software dit kan omdat humor een complex fenomeen is. Het heeft te maken heeft met stereotyperingen, onze geschiedenis, sociologische aspecten, populaire cultuur, onderlinge afspraken et cetera. AI-software gaat dus steeds meer begrijpen over context.

Je kunt je voorstellen dat social media moderators deze software ook tot hun beschikking gaan krijgen omdat ze zo aanstootgevende memes kunnen herkennen, omdat het AI-systeem immers de stereotypering en de context achter de beelden begrijpt.

Gevaren

Dat AI-systemen videomateriaal kunnen analyseren en de bijbehorende context snappen is een aspect van de toekomst van kunstmatige intelligentie dat wat mij betreft heel erg onderbelicht blijft. En dat is bedreigend. Want hoewel bovengenoemde ontwikkelingen natuurlijk boeiend zijn, vormen ze ook zeker een gevaar. Niet alleen omdat AI-systemen nu nóg weer veel slimmer worden omdat ze op nieuwe reusachtige bergen data getraind worden. Maar dit soort AI-systemen kunnen namelijk ook worden ingezet worden door kwaadwilligen. Zij krijgen als het ware extra zintuigen in de digitale wereld.

Allereerst is er het risico van ongewenste surveillance. Wanneer AI-systemen videomateriaal kunnen analyseren en de bijbehorende context snappen, kunnen ze ook door overheden worden ingezet voor spionage of sociale profilering. Ten tweede maken ze de mogelijkheid van censuur veel groter. Veel online content met een politieke of activistische inslag wordt momenteel nog niet herkend door softwarefilters, omdat het verpakt is in afbeeldingen en video’s. Dat kan echter veranderen als AI de context van afbeeldingen en video’s ‘begrijpt’. Als laatste kan de software ook gebruikt worden voor de ongeoorloofde analyse van persoonlijke video’s en afbeeldingen om op deze wijze mogelijke gevoelige en privégegevens te verzamelen zonder toestemming.

Deze drie concrete risico’s zijn op zich al zorgelijk, vooral als een te machtige overheid of georganiseerde criminaliteit de beschikking krijgt over dergelijke multimodale AI-systemen.

Zorgen rondom multimodaliteit

Maar bij mij geven ze ook nog aanleiding ook een andere zorg.

Stel je eens voor dat de multimodale AI-systemen van Google getraind worden op de reusachtige berg van alle (!) YouTube filmpjes wereldwijd. (doen ze nu al met YouTube shorts) Video’s van bedrijfsuitjes, vakanties, reparaties, politieke documentaires, muziekconcerten, stand up comedy, samenzweringstheorieën en onderwijscolleges. En dat het bedrijf gebruik maakt van de reusachtige grote hoeveelheden foto’s en video’s die smartphonegebruikers wereldwijd bij hen in de cloud hebben staan. Een nieuwe, diepe goudmijn van data. Dit soort databases zijn een spiegel van ons leven en hiermee krijgt Big Tech een nóg scherpere kijk op wie wij zijn. Pixels geven onze geheimen bloot en zo kunnen commerciële technologiebedrijven nóg meer van ons leven ontcijferen. Ze kijken als het ware in ons digitale spiegelbeeld.

Inbreuk collectieve privacy

Ik ben bezorgd dat met behulp deze gigantisch grote berg van nieuwe data steeds meer ons onderbewustzijn bij de technologiebedrijven in kaart gebracht wordt; die blinde vlekken waarvan we zelf geen weet hebben. Dat ze beetje bij beetje onze – bij gebrek aan een beter woord – ‘broncode’ weten te ontdekken.

Vanzelfsprekend zullen technologiebedrijven deze informatie gebruiken om ons nog beter te sturen en te manipuleren in de richting van specifiek koopgedrag. Maar ik vind het vooral bezwaarlijk een moreel onjuist omdat het een nog grotere inbreuk is op onze collectieve privacy. Het is belangrijk dat we ons daar bewust van worden.